Minh họa: T.ĐẠT - Hình vẽ sử dụng công nghệ AI

Thông qua các ứng dụng OTT (cung cấp nội dung hình ảnh, tin nhắn, gọi điện như Viber, Zalo, Messenger...), kẻ xấu có thể thực hiện cuộc gọi thoại, thậm chí cả video với giọng nói, hình ảnh là của người thân, người quen, sếp... khiến người nhận rất khó phân biệt thật giả và sập bẫy lừa đảo cuộc gọi Deepfake.

Đó là việc dùng cuộc gọi video Deepfake để lừa đảo. Deepfake là công nghệ ứng dụng trí tuệ nhân tạo (AI) để tạo ra các đoạn video với hình ảnh khuôn mặt nhân vật giống hệt như hình ảnh người dùng muốn giả mạo. Từ một công nghệ phục vụ giải trí nay những kẻ lừa đảo, tung tin giả đã ứng dụng Deepfake vào các chiêu trò của mình, tạo nên một cách thức lừa đảo mới vô cùng hiểm độc.

Nhiều người bị lừa cuộc gọi Deepfake

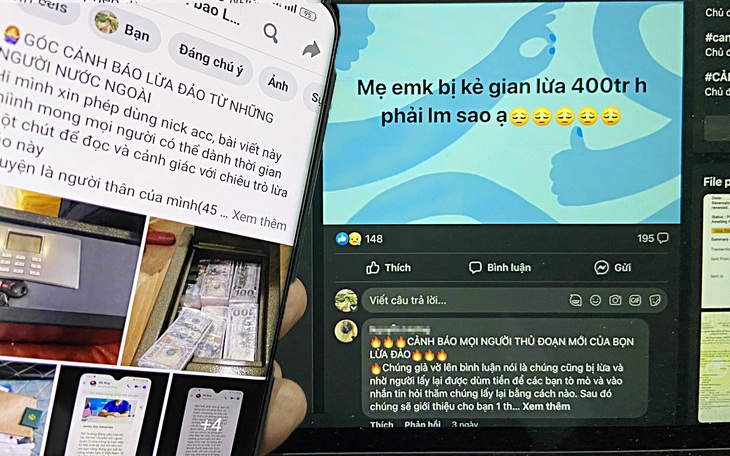

Ngay sau bài viết của báo Tuổi Trẻ về "Cuộc gọi video giờ thấy mặt cũng chưa chắc chính chủ" (Tuổi Trẻ 27-3), nhiều người dùng cho biết đã từng là nạn nhân của chiêu trò lừa đảo từ cuộc gọi video Deepfake như trong bài viết. Chị Mỹ Tâm (TP.HCM) cho biết đã bị lừa mất 30 triệu đồng bởi chiêu trò gọi điện video Deepfake.

Cụ thể, tài khoản người thân chị Tâm bên Mỹ nhắn tin mượn tiền vì có việc gấp. Liền sau đó chị Tâm nhận được cuộc gọi video qua ứng dụng Messenger của Facebook.

"Cuộc gọi chỉ diễn ra được vài giây nhưng đủ để tôi thấy được khuôn mặt người thân của mình cùng với cách xưng hô quen thuộc nhưng chập chờn. Sau đó tôi nhận được tin nhắn vì sóng yếu nên không gọi video tiếp được, chuyển sang nhắn tin cho tiện. Tôi tin tưởng và chuyển tiền theo hướng dẫn không chút nghi ngờ", chị Tâm kể lại.

Tương tự, chị Thu Hòa (TP.HCM) cũng bị lừa 20 triệu đồng với cùng chiêu lừa như trên. "Sáng tôi đã chuyển tiền cho bạn mình sau cuộc gọi video qua Facebook từ bạn. Đến chiều tôi mới nhận được tin nhắn cảnh báo tài khoản Facebook của bạn tôi đã bị hack. Tôi liền gọi điện thoại cho bạn thì mới biết kẻ xấu đã dùng chiêu gọi video mạo danh để lừa tôi", chị Hòa bộc bạch.

Trao đổi với Tuổi Trẻ, ông Vũ Thanh Thắng - giám đốc cấp cao về AI Công ty an ninh mạng thông minh SCS - cho biết Deepfake là một công nghệ AI có khả năng làm giả video với hình ảnh và giọng nói của một người khác.

Kịch bản lừa đảo diễn ra như: kẻ lừa đảo tìm cách chiếm đoạt tài khoản Zalo, Facebook của người dùng, tiếp đó thu thập hình ảnh (có thể cả giọng nói của nạn nhân từ các video) và dùng Deepfake tạo ra đoạn video mạo danh.

Sau đó kẻ lừa đảo tiến hành nhắn tin mượn tiền những người dùng trong danh sách bạn bè Facebook của nạn nhân, đồng thời thực hiện cuộc gọi video mạo danh, phát video giả mạo để tăng độ tin cậy nhằm lừa đảo thành công hơn.

"Thường những cuộc gọi video giả mạo này sẽ rất ngắn với mục đích cho bạn bè hay người thân của nạn nhân nhìn thoáng qua, sau đó tắt đi với lý do sóng điện thoại kém. Mấu chốt của việc lừa đảo này là để nạn nhân tin rằng bạn bè, người thân của mình đang gặp vấn đề và cần giúp đỡ, gửi tiền gấp. Với cách thức này, những người không để ý hoặc trung niên... chỉ nhìn thoáng qua có thể sập bẫy kẻ gian", ông Thắng phân tích.

Với Deepfake, kẻ xấu có thể thực hiện một cuộc gọi video qua ứng dụng OTT với hình ảnh, giọng nói mạo danh người khác dễ dàng - Ảnh: Q.ĐỊNH

Từ ghép hình đến video Deepfake

Vài năm trở lại đây, một trong những chiêu trò đòi nợ kiểu khủng bố xuất hiện nhiều tại Việt Nam là gán ghép hình ảnh "con nợ" hoặc người thân, sếp của "con nợ" rồi bêu xấu trên mạng. Các chuyên gia công nghệ cho rằng sắp tới rất có khả năng kẻ lừa đảo dùng Deepfake để tạo ra những video giả, gán ghép hình ảnh nhằm đạt được các mục đích xấu.

Trao đổi với Tuổi Trẻ chiều 29-3, ông Vũ Ngọc Sơn - giám đốc công nghệ Công ty an ninh mạng NCS - cho biết các chiêu trò, hình thức lừa đảo gần đây đều không phải mới nhưng các đối tượng lừa đảo đã biết ứng dụng công nghệ, đặc biệt công nghệ AI. Từ đó khả năng thành công của các chiêu lừa đảo sẽ cao hơn và ngày càng khó lường với người dùng Internet.

Theo ông Sơn, với sự phát triển của AI, các ứng dụng kiểu như Deepfake sẽ giúp một người bình thường, không cần biết về công nghệ hay xử lý đồ họa cũng có thể dễ dàng thực hiện được việc ghép ảnh, ghép video, thậm chí là cả giọng nói.

Chính vì vậy, ông Sơn cảnh báo: "Tình trạng lừa đảo bằng Deepfake có thể sẽ bùng phát trong thời gian tới, bởi số tiền các đối tượng chiếm được qua mỗi vụ việc là khá lớn trong khi công sức chúng bỏ ra không nhiều".

Còn theo Hãng bảo mật Kaspersky, hiện nay video Deepfake vẫn ở trong giai đoạn có thể nhận biết được nếu người xem chú ý vào các đặc điểm như: chuyển động bị giật, thay đổi ánh sáng từ khung hình này sang khung hình khác, thay đổi tông màu da, chớp mắt một cách khác thường hoặc hoàn toàn không chớp mắt, khẩu hình và âm thanh không khớp...

"Tuy nhiên Deepfake đang trở thành mối đe dọa thật sự. Các video Deepfake được tạo nên ngày càng thật hơn, thậm chí đã được dùng cho mục đích chính trị cũng như trả thù cá nhân. Thông dụng nhất, gần đây video Deepfake được sử dụng thường xuyên cho mục đích tống tiền và lừa đảo", đại diện Kaspersky cảnh báo.

Kỹ thuật biên tập video hiện đại cho phép người sản xuất có thể biến hình nhân vật trong video khác xa thực tế - Ảnh: Q.ĐỊNH

Deepfake là gì?

Theo Hãng bảo mật Kaspersky, Deepfake là một từ ghép của "deep" trong "deep learning" (học sâu) và "fake" (giả mạo). Deep learning là dùng phương pháp AI tiên tiến ứng dụng nhiều thuật toán nhằm tổng hợp dần các tính năng cao cấp từ dữ liệu đầu vào. Từ đó nó có khả năng tổng hợp, học hỏi từ những dữ liệu mà người dùng đưa vào như khuôn mặt con người, chuyển động vật lý và giọng nói…

Từ các dữ liệu này, AI sau đó sẽ xử lý để tạo ra video Deepfake thông qua mạng GAN (Generative Adversarial Network - dịch nôm na: mạng sinh ra dữ liệu mới sau quá trình học). Mạng lưới này liên tục kiểm tra các hình ảnh, âm thanh, chuyển động… được tạo ra theo chương trình thiết lập từ trước. Từ đó các video Deepfake cuối cùng sẽ cho ra hình ảnh ngày càng thuyết phục, sống động và thật hơn.

Bình tĩnh để tránh bị lừa

Chuyên gia Ngô Minh Hiếu, Trung tâm Giám sát an toàn không gian mạng quốc gia, cho rằng để tránh bị lừa thì tốt nhất người dân nên tỉnh táo trong mọi tình huống. Khi có một ai đó trên mạng xã hội trong danh sách bạn bè của mình mà tự nhiên hỏi mượn tiền hay gửi link lạ thì không nên vội mà hãy bình tĩnh, kiểm chứng và nên xác thực mọi thứ.

Chủ động xác thực bằng cách gọi điện thoại trực tiếp hoặc facetime (mặt đối mặt) ít nhất trên một phút, sau đó giả vờ đặt ra những câu hỏi cá nhân mà chỉ có bạn và người kia mới biết. Vì Deepfake sẽ không thể giả được một cuộc trò chuyện thật sự trong thời gian thực mang tính chuẩn xác cao. Bởi tính tới thời điểm này dù sao cảm xúc hay biểu cảm của AI hay Deepfake vẫn không thể bắt chước được người thật.

Công an TP.HCM cảnh báo về lừa đảo bằng công nghệ Deepfake

Thông tin từ Công an TP.HCM cho biết chưa ghi nhận thông tin phản ảnh về trường hợp bị lừa đảo mà kẻ lừa đảo sử dụng công nghệ Deepfake. Theo Công an TP.HCM, những kẻ lừa đảo có thể gọi video để giả làm người thân vay tiền, giả làm con cái đang du học nước ngoài gọi điện cho bố mẹ nhờ chuyển tiền đóng học phí...

Nắm bắt được tâm lý người dùng mạng xã hội hiện nay đã cảnh giác với chiêu trò lừa đảo bằng tin nhắn nhờ chuyển tiền, kẻ xấu đã sử dụng chiêu lừa đảo tinh vi hơn để vay tiền thông qua hình thức giả cuộc gọi video Deepfake. Thủ đoạn là lấy những video cũ của người dùng, cắt ghép hoặc dùng công nghệ Deepfake để khi lừa đảo sẽ phát lại video dưới hình thức mờ ảo, chập chờn như đang ở nơi sóng yếu.

Công an TP.HCM khuyến cáo khi nhận bất kỳ tin nhắn vay mượn tiền thông qua mạng xã hội, người dân cần điện thoại trực tiếp cho người thân để xác minh. Trường hợp nghi vấn kẻ giả mạo cần báo ngay cho cơ quan công an gần nhất để được hỗ trợ, xử lý kịp thời.

ĐAN THUẦN

Khi Deepfake bị lợi dụng

Khuôn mặt chân dung của một người không có thực do Deepfake tạo ra trên trang web: https://this-person-does-notexist.com

Trên thế giới, xét dưới góc độ kinh tế - xã hội, ngoài việc giải trí, công nghệ Deepfake còn được dùng với thủ đoạn xấu nhằm lừa đảo tài chính, bôi xấu, khủng bố, đe dọa…

Còn xét riêng về mặt an ninh, tình báo, Deepfake thậm chí có thể trở thành công cụ nhằm tung hỏa mù, thậm chí có thể gây ra hiểm họa của an ninh toàn cầu.

Tấn công tài chính

Tháng 3-2019, giám đốc điều hành một công ty năng lượng ở Anh nhận được cuộc gọi từ sếp của mình. Vị giám đốc điều hành ở công ty mẹ đặt tại Đức yêu cầu ông chuyển tiền gấp cho một nhà cung cấp ở Hungary trong vòng một giờ. Không chút nghi ngờ, vị CEO chuyển khoản và mất 243.000 USD. Số tiền nhanh chóng được chuyển từ tài khoản ngân hàng Hungary sang một tài khoản ở Mexico, sau đó được chuyển tiếp đến các nơi khác.

Theo tạp chí Forbes, đây là trường hợp lừa đảo đầu tiên được ghi nhận liên quan đến việc giả giọng nói bằng công nghệ Deepfake. Nạn nhân cho biết đã nghe âm thanh giống với tiếng của sếp mình bởi âm sắc đặc trưng của người Đức. Kẻ lừa đảo còn gọi để đòi một khoản thanh toán thứ hai nhưng lúc này nạn nhân sinh nghi và không chuyển khoản.

Trường hợp lừa đảo do Deepfake thứ hai được xác định ở Hong Kong. Tháng 1-2020, giám đốc một ngân hàng nhận được cuộc gọi từ một người có giọng nói giống giọng và hình ảnh của giám đốc một công ty ông từng nói chuyện.

Vị giám đốc thông báo tin mừng: Công ty của ông sắp thực hiện một thương vụ mua lại. Ông cần ngân hàng cho phép một số giao dịch chuyển khoản trị giá 35 triệu USD. Ngoài cuộc gọi, giám đốc ngân hàng còn nhận được các email mà ông tin là từ vị giám đốc. Nội dung điện thoại và email đều liên quan đến việc mua lại một công ty. Tin rằng mọi thứ đều hợp pháp, giao dịch chuyển tiền được thực hiện và ngân hàng bị thiệt hại 35 triệu USD.

Một nghiên cứu gần đây cho thấy chỉ trong năm 2020, gian lận danh tính do Deepfake tạo ra đã gây thiệt hại cho các tổ chức tài chính khoảng 20 tỉ USD. Trung bình một kẻ lừa đảo thông qua Deepfake để đánh cắp từ 81.000 đến 97.000 USD trước khi vụ lừa đảo bị phanh phui. Một báo cáo khác cho thấy "những người cho vay trực tuyến cũng mất 6 tỉ USD mỗi năm do gian lận danh tính và đây là tội phạm tài chính phát triển nhanh nhất thế giới", theo pymnts.com.

Gây khủng hoảng an ninh toàn cầu

Một báo cáo mới của các chuyên gia AI cũng đưa ra dự đoán rằng công nghệ Deepfake đang trên đà được sử dụng rộng rãi hơn trong các hoạt động tình báo và quân sự có mục tiêu. Chủ nhiệm Phòng thí nghiệm AI và an ninh Northwestern, ông Subrahmanian, và nhóm sinh viên của mình đã phát triển một thuật toán tạo ra các video Deepfake nhằm cảnh báo về rủi ro xung đột toàn cầu từ Deepfake.

Họ đã tạo ra video giả về trùm khủng bố Nhà nước Hồi giáo đã chết là Abu Mohammed al-Adnani.

Trong video, nét mặt và âm thanh của Abu Mohammed al-Adnani hiện ra chân thực, còn những gì người này nói là phát ngôn của Tổng thống Syria Bashar al-Assad. Video Deepfake sống động này được tạo ra chỉ trong vài giờ. Quá trình đơn giản đến mức Subrahmanian cảnh báo các cơ quan an ninh nên sẵn sàng cho việc kẻ xấu có khả năng tạo ra video Deepfake về bất kỳ quan chức hoặc lãnh đạo nào trong tương lai.

Tác giả đề nghị chính phủ các nước nên có chính sách giám sát và quản lý việc tạo và phát tán các nội dung Deepfake. Chẳng hạn cần có "quy trình Deepfake" trước khi muốn sử dụng công nghệ này.

"Quyết định tạo ra và sử dụng Deepfake không nên được xem nhẹ mà cần được xem xét cẩn thận về mọi mặt của rủi ro. Việc sử dụng Deepfake được thiết kế đặc biệt để tấn công các mục tiêu có giá trị cao trong bối cảnh xung đột sẽ ảnh hưởng đến nhiều cơ quan và văn phòng chính phủ", nhóm tác giả trên đưa ra cảnh báo.

HỒNG VÂN

Tối đa: 1500 ký tự

Hiện chưa có bình luận nào, hãy là người đầu tiên bình luận