Một số đoạn văn bản được AI tạo ra - gọi là "ảo giác" - có thể bao gồm các bình luận về chủng tộc, ngôn từ bạo lực và thậm chí là các phương pháp điều trị y tế tưởng tượng - Ảnh: AP

Theo AP, từ phỏng vấn với các kỹ sư phần mềm, nhà phát triển và nhà nghiên cứu học thuật, các chuyên gia cho biết một số đoạn văn bản do AI tạo ra là không có thật, được gọi là "ảo giác". Đáng nói, chúng bao gồm các bình luận về chủng tộc, ngôn từ bạo lực và thậm chí là các phương pháp điều trị y tế tưởng tượng.

Tỉ lệ "ảo giác" cao trong các văn bản do AI tạo ra

Các chuyên gia đặc biệt lo ngại vì Whisper đang được sử dụng rộng rãi trong nhiều ngành trên toàn thế giới để dịch và chuyển đổi các cuộc phỏng vấn, tạo văn bản trong các công nghệ tiêu dùng phổ biến và tạo phụ đề cho video.

Đáng lo hơn là nhiều trung tâm y tế đang sử dụng Whisper để chuyển đổi các cuộc tư vấn giữa bác sĩ và bệnh nhân, mặc dù OpenAI đã cảnh báo rằng công cụ này không nên được sử dụng trong những lĩnh vực "rủi ro cao".

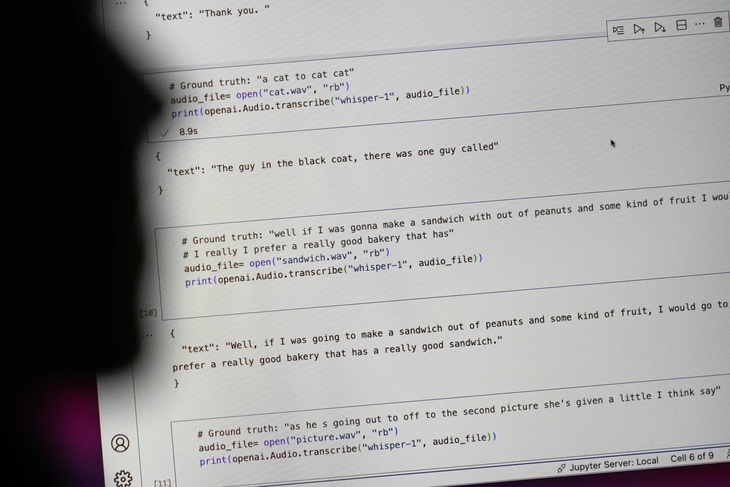

Mức độ đầy đủ của vấn đề khó mà xác định được, nhưng các nhà nghiên cứu và kỹ sư cho biết trong công việc họ thường xuyên gặp phải các "ảo giác" của Whisper.

Một nhà nghiên cứu tại Đại học Michigan kể anh phát hiện thấy "ảo giác" ở tám trong mười bản chuyển đổi âm thanh mà anh kiểm tra. Một kỹ sư máy tính phát hiện "ảo giác" trong khoảng một nửa số bản chuyển đổi hơn 100 giờ âm thanh mà anh phân tích. Một nhà phát triển khác cho biết anh phát hiện "ảo giác" gần như ở tất cả 26.000 bản ghi mà anh tạo ra bằng Whisper.

Vấn đề vẫn tiếp tục ngay cả với các mẫu âm thanh ngắn, được ghi âm rõ ràng. Một nghiên cứu gần đây của các nhà khoa học máy tính đã phát hiện 187 "ảo giác" trong hơn 13.000 đoạn âm thanh rõ ràng mà họ đã kiểm tra. Xu hướng này sẽ dẫn đến hàng chục ngàn bản chuyển đổi sai trong hàng triệu bản ghi âm, các nhà nghiên cứu cho biết.

Những sai sót như vậy có thể dẫn đến "hậu quả rất nghiêm trọng", đặc biệt là trong môi trường bệnh viện, theo bà Alondra Nelson - người từng đứng đầu Văn phòng Khoa học và Công nghệ của Nhà Trắng trong chính quyền của Tổng thống Biden cho đến năm ngoái.

"Không ai muốn một chẩn đoán sai", bà Nelson, hiện là giáo sư tại Viện Nghiên cứu cao cấp tại Princeton, New Jersey, nhấn mạnh. "Cần phải có một tiêu chuẩn cao hơn".

Whisper cũng được sử dụng để tạo phụ đề cho người điếc và khiếm thính - một đối tượng đặc biệt có nguy cơ cao đối với các bản chuyển đổi sai. Điều này là do người điếc và khiếm thính không có cách nào để xác định các đoạn văn bịa đặt "ẩn trong tất cả các văn bản khác", ông Christian Vogler, người điếc và là giám đốc Chương trình Tiếp cận công nghệ tại Đại học Gallaudet, nói.

OpenAI được kêu gọi giải quyết vấn đề

Sự phổ biến của các "ảo giác" như vậy đã khiến các chuyên gia, những người ủng hộ và cựu nhân viên của OpenAI kêu gọi chính phủ liên bang xem xét các quy định về AI. Tối thiểu, OpenAI cần phải giải quyết lỗi này.

"Vấn đề này có thể giải quyết được nếu công ty sẵn lòng ưu tiên nó", ông William Saunders, kỹ sư nghiên cứu ở San Francisco, người đã rời khỏi OpenAI vào tháng 2 vì lo ngại về hướng đi của công ty, nhận định.

"Sẽ là vấn đề nếu bạn đưa nó ra và mọi người quá tự tin về những gì nó có thể làm rồi tích hợp nó vào tất cả các hệ thống khác". Một phát ngôn viên của OpenAI cho biết công ty liên tục nghiên cứu cách giảm thiểu các "ảo giác" và đánh giá cao những phát hiện của các nhà nghiên cứu, đồng thời cho biết OpenAI tích hợp phản hồi trong các cập nhật mô hình.

Mặc dù hầu hết các nhà phát triển giả định rằng các công cụ chuyển văn bản có thể sai chính tả hoặc mắc lỗi khác, các kỹ sư và nhà nghiên cứu cho biết họ chưa từng thấy một công cụ chuyển văn bản nào do AI hỗ trợ lại gặp "ảo giác" nhiều như Whisper.

Tối đa: 1500 ký tự

Hiện chưa có bình luận nào, hãy là người đầu tiên bình luận